Informatique Quantique : De la Fiction à la Réalité

On ne serait pas étonné d’apprendre que l’idée de réalisation du calculateur quantique est née sous le toit de ceux qui font de la recherche dans les divers domaines liés à la théorie quantique. Sachant que ce sont des domaines fortement exigibles en calculs scientifiques parmi les plus complexes que l’on peut imaginer, dès que l’on sort de quelques cas triviaux.

Théoriciens et simulateurs quantiques se sont toujours plaints des temps de calculs écoulés pour aboutir aux premiers résultats, et de là a été fait le constat de la complexité à simuler des systèmes quantiques par des ordinateurs classiques. Cette complexité provient notamment de la propriété que possèdent ces systèmes de pouvoir se trouver simultanément dans une superposition d’états. C’est pour répondre à ces plaintes, que l’idée de réaliser un calculateur quantique est née par retournement dans l’esprit du physicien américain Richard Feynman qui a proposé de construire un ordinateur quantique qui exploiterait le parallélisme quantique et permettrait ainsi de simuler efficacement le comportement de tout système. En 1982, Il écrit « au lieu de nous plaindre que la simulation des phénomènes quantiques demande des puissances énormes à nos ordinateurs actuels, utilisons la puissance de calculs des phénomènes quantiques pour faire plus puissant que nos ordinateurs actuels ».

Qui est Richard Feynman ? Né le 11 mai 1918 près de Ney York, R. Feynman devient docteur en physique et au même temps occupe le poste de Professeur titulaire dès l’âge de 24 ans, à l’université de Princeton (USA). Son obtention du Prix Nobel de Physique en 1965 a fait de lui l’un des physiciens les plus influents de la deuxième moitié du XXe siècle. Ses travaux ne sont se pas limités aux domaines qui nous sont connus, et qui sont l’électrodynamique quantique et la superfluidité de l’Hélium, mais aussi des domaines très variés tels que la météorologie, la physique de la foudre, l’astrophysique, la physique des particules etc…Il est connu surtout par son diagramme collisionnaire entre particules, qui est repris par toutes les branches de physique faisant appel à la théorie quantique.

Pour plusieurs ouvrages de physique générale « The Feynman Lectures in physics »qu’il a publiés, on peut affirmer qu’ils ont eu un très large succès, tant aux Etats Unis que dans un nombre important de pays y compris le Maroc. Cela s’est traduit en particulier par la très grande diffusion de ses ouvrages, qui tantôt en langues anglaise, tantôt en édition bilingue, rassemblaient l’ensemble de ses cours. A travers ces cours, il a réussi à nous donner une idée simple, précise et enthousiaste de ce que c’est la physique d’aujourd’hui, sans négliger ses fondements les plus traditionnels. A les comparer aux livres russes des Edition MIR de Moscou, c’est une nette différence en tout point de vue, car ces derniers sont connus par la longévité de leurs calculs, qui parfois font frôler la perte du raisonnement et poussent parfois à se demander s’il reste encore un sens physique derrière leurs calculs interminables.

C’est un succès qui tient aussi à une autre raison, qui est le style d’approche de la physique chez Feynman à même d’échapper à l’outillage lourd imposé par les mathématiques, pour faire en sorte que cet outillage ne vient pas entraver la compréhension des phénomènes physiques. Bien au contraire cet outillage est bien conçu pour répondre aux problèmes que pose le physicien. Sa façon de présenter ses idées parait à tout le monde comme très personnalisée, où l’on peut voir tout au long des lignes, sa pensée personnelle s’exprimer en un perpétuel jaillissement. Ce perpétuel jaillissement a fait de lui le visionnaire par retournement de la cause vers l’effet et de l’effet vers la cause. Complexités des calculs quantiques a fait jaillir cette idée de retourner le processus quantiques pour faire des calculs et rendre plus simples ce qui est complexe. Ainsi est née l’idée du calculateur quantique chez Feynman, qui n’a cessé d’en faire sa cause depuis sa déclaration à ce sujet depuis 1982. Mort le 11 février 1988, et bien qu’ayant bien approfondi théoriquement l’électrodynamique quantique, il a toujours laissé planer le doute sur cette partie de la physique quantique que le postulat de la mesure pénalisait et la rendait incomplète. C’est S. Haroche Prix Nobel de physique 2012 qui pu a donner la réponse à cette question.

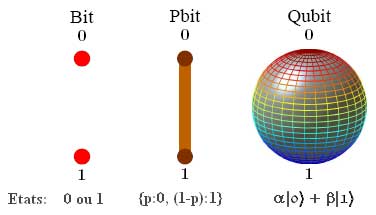

Pourquoi le calculateur quantique ? Selon l’empirique loi de Moore, stipulant que le volume exigé par l’espace d’occupation des composants électroniques diminue de moitié tous les 18 mois, la taille des transistors approchera celle de l’atome à l’horizon de 2020. A cette échelle, les effets quantiques perturbent le fonctionnement des composants. Si de grands calculateurs quantiques pouvaient être construits, ils seraient capables d’après D. Deutsch de simuler le comportement de l’univers tout entier. Ils pourraient également résoudre des problèmes de cryptanalyse en des temps polynomiaux et non exponentiels comme c’est le cas pour un ordinateur classique. Faisant usage surtout de l’algèbre linéaire classique, le calculateur quantique repose sur deux propriétés quantiques principales qui sont la superposition et l’intrication.

Maintenant que les physiciens ont fait ce qu’il a fallu faire en élaborant le principe de production du QuBit, c’est au matheux et aux informaticiens spécialistes des algorithmes de porter le flambeau de faire aboutir ce processus et veiller à sa concrétisation. Quels sont les problèmes et les obstacles qui guettent le développement de ce processus dont les résultats se seraient pas certains, surtout dans l’immédiat. Le message lancé par Feynman n’est pas resté longtemps sans écho, et dès l’année 1984 une première tentative est venue de C. H. Bennett et G. Brassard. Ces deux derniers ont mis le premier protocole de distribution de clé quantique intitulé BB84, dont la sécurité repose sur l’utilisation de photons comme QuBits, avec les deux principes physiques sui sont le théorème de non-clonage et le postulat de réduction du paquet d’onde. C’est une proposition qui a été accueillie avec scepticisme, dû principalement au fait que les sources de photons qu’ils avaient proposées d’utiliser sont des sources de photons uniques, c’est-à-dire des sources capables d’émettre un seul photon à la fois. Or, il était encore impensable à cette époque que de telles sources puissent exister, et ce protocole a été refusé dans toutes les revues spécialisées de bonne réputation.

En 1985, D. Deutsch publie un travail dans lequel il décrit le premier algorithme, connu sous le nom d’algorithme de Deutsch. Bien qu’il ne possède pas réellement d’utilité pratique, il est d’un intérêt surtout théorique évident puisqu’il a accompli sa tâche de premier algorithme quantique, plus efficace que tout algorithme classique. Il est généralisé en 1992 sous le nom d’algorithme de Deutsch-Jozsa. En 1993, E. Bernstein et U. Vazirani ont démontré qu’il est possible d’avoir une machine quantique capable de simuler tout système quantique en temps polynomial.

En 1994, P. Shor dévoile l’algorithme qui porte son nom : algorithme de Shor. Il marque véritablement le début de l’engouement par le calcul quantique, car c’est le premier algorithme quantique plus efficace qu’un algorithme classique qui soit d’un intérêt pratique. En l’occurrence, il permet de factoriser un nombre entier en temps polynomial. Sa première implémentation pratique a eu lieu en 2001, et a permis de factoriser 15 en 3 multiplié par 5. Cet algorithme est basé sur la transformée de Fourier quantique, dont l’implémentation sur un ordinateur quantique a été démontrée la même année. En 1995, B. Schumacher a établi le théorème dans lequel il définit le QuBit comme unité physique d’information quantique. En 1996, L. Grover découvre un algorithme de recherche quantique plus efficace que tout autre algorithme de recherche classique.

Ainsi avec la naissance du QuBit et des algorithmes bien élaborés, l’informatique quantique est née comme sous-domaine de l’information quantique qui cherche à exploiter le parallélisme quantique afin de mettre au point des ordinateurs quantiques. On peut cependant faire la distinction entre software et hardware. D’un côté, les mathématiciens et informaticiens tentent de mettre au point des algorithmes quantiques, c’est-à-dire des algorithmes implémentables sur un calculateur quantique exploitant en particulier le parallélisme quantique. Aujourd’hui, les plus connus sont les algorithmes de Shor et de Grover. D’un autre côté, on retrouve les physiciens adeptes de Feynman, qui cherchent des systèmes physiques les plus aptes à implémenter un ordinateur quantique.

L’informatique quantique existe donc à ce jour, mais se heurte encore à des difficultés expérimentales considérables. En particulier, un des éléments central d’un ordinateur quantique que sont les mémoires quantiques sont encore loin d’être au point, ce qui limite pour l’instant le développement à grande échelle des implémentations pratiques. La mémoire d’un ordinateur classique est faite de bits, et un ordinateur quantique travaille sur un jeu de QuBits qui portent soit un un ou un zéro, soit une superposition d’un un et d’un zéro. Plus exactement, il porte une distribution de phase, angle qui pour 0° lui fait prendre la valeur 1, pour 90° la valeur 0 et entre les deux une infinité de superpositions d’états dans des proportions bien déterminées. L’ordinateur quantique calcule en manipulant ces distributions, avec non seulement trois états, mais avec une infinité d’états. De plus, l’état de plusieurs QuBits réunis n’est pas seulement une combinaison de leurs ’états respectifs, mais le double. En effet deux QuBits réunis sont dans une superposition de quatre états, c’est pourquoi la puissance de calcul théorique d’un ordinateur quantique double à chaque fois qu’on lui adjoint un QuBit. Par exemple avec 10 QuBits, ont 1024 état superposés.

Plus fondamentalement, on se heurte à un paradoxe : on demande aux QuBits d’être isolés de l’extérieur pendant le calcul proprement dit, ceci afin de limiter les effets de décohérence, mais dans le même temps, on souhaite conserver une possibilité d’interaction avec le système afin d’effectuer la mesure pour l’obtention du résultat. Ces deux critères sont difficilement conciliables, sachant aussi que l’implémentation des portes quantiques est également limitante. Celles-ci doivent être plus fiables, dans le sens d’accomplir l’opération souhaitée avec une grande probabilité, et rapides, de façon à agir plus vite que le temps de décohérence des QuBits.

Enfin signalons que tous les algorithmes quantiques sont par essence probabilistes, ce qui signifie qu’ils ont une certaine probabilité de fournir un résultat correct. A ce jour, la question de savoir si un ordinateur quantique est foncièrement plus efficace qu’un ordinateur classique est toujours ouverte, car le problème principal réside dans la production des QuBits. A ce sujet, plusieurs projets sont en cours à travers le monde pour construire concrètement des QuBits viables et les réunir dans un circuit. Ces recherches mettent en œuvre la physique théorique très pointue (voir les articles : Prix Nobel de physique 2012 comme prolongement historique de la théorie quantique, Libération 3, 4 et 5 Décembre 2012).

Les circuits supraconducteurs avec jonction Josephson donnent une technique très malléable, qui consiste à dessiner des circuits suffisamment résistants à la décohérence. Pour l’instant, elle ne permet de coupler que deux QuBits, mais des recherches sont en cours pour en coupler davantage à l’aide d’un mécanisme de résonance. Les ions piégés de Wineland et les atomes de Rydberg dans une cavité résonante de Haroche ont déjà donné plus de Qubits intriqués. La résonance magnétique nucléaire, le condensat de Bose-Enstein piégé dans un réseau optique avec d’autres projets sont dans la course pour la production de plus d’un Qubit.

Un domaine intéressant est en train d’être investi, c’est celui des boites quantiques où les deux auteurs de cet article, au sein de leur équipe, ont beaucoup travaillé et contribué à l’étude des diverses propriétés physiques (optiques, électroniques, thermiques et mécaniques). Ils ont eu un grand nombre de publications sorties dans des revues internationales de renommée, surtout dans la première moitié de la décennie passée. En anglais Quantum Dots, ce sont des systèmes macroscopiques qui possèdent, malgré tout, les caractéristiques quantiques nécessaires pour l’élaboration d’un ordinateur quantique. On appelle parfois de tels systèmes par des atomes artificiels. C’est une technique qui utilise des matériaux courants dans l’industrie des semi-conducteurs : silicium ou arséniure de gallium. Elle se subdivise en deux branches : l’une exploitant la charge électrique des QuBits, l’autre leur spin et s’intitule électronique du spin ou encore Spintronique.

Plusieurs projets semblent susceptibles d’exploitation industrielle, mais les problèmes de base demeurent toujours. Des recherches sont ainsi entreprises pour réaliser un ordinateur quantique à base solide, comme le sont les microprocesseurs actuels. Et même si les problèmes techniques posés par la réalisation des ordinateurs quantiques étaient résolus à terme, leur avenir commercial ne se situe pas dans le grand public et tout dépendra du coût à leur fabrication. Les pays où ces recherches sont menées sont malheureusement ceux secoués par la crise économique et financière, ce qui peut grever fortement les budgets qui leur sont alloués. Donnons quelques chiffres concernant quelques pays se déclarant pionniers dans ce genre d’activités à cheval entre recherche développement (RD)et recherche fondamentale. Les Etats-Unis consacrent 75 millions d’euros, le japon 25 millions d’euros, le canada 12 millions d’euros, l’Australie 6 millions d’euros contre 8 millions pour l’Union Européenne.

Professeur et Directeur de Laboratoire de Recherche De Physique